ディープラーニングのアルゴリズムを使って既存のムービーに登場する人物を編集する新しい技術「Deep Video」をスタンフォード大学のMichael Zollhöfer准教授らが発表しました。この技術を用いれば、1つのムービーに登場する人物が言葉を話す様子やジェスチャーを、別のムービーの人物にまるまる移植することができます。

2017年12月にAIがAVの顔面部分に有名人を合成する「フェイクポルノ」が話題となり、技術を乱用することで偽のニュースが作成可能となることが問題視されました。実際に、バラク・オバマ元大統領の映像に別のムービーの表情を移植するという技術が、この時点で発表されています。一方でZollhöfer准教授らが開発した技術の新しい点は、表情だけにとどまらず、頭の位置や動き、目の動き、まばたきに至るまで移植可能であるという点です。

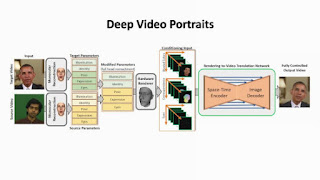

Zollhöfer准教授らの技術は、表情を変更したいムービーのほかに、移植する表情などの「ソース」となる役者の動きを収めたムービーを必要とします。ソースとなる役者は年齢や性別などを問いません。

以下のように、表情だけでなく、顔の向きや動きまで移植可能。

もちろん、動きはそのままに、表情だけを移植することも可能です。

つまり、音声さえ用意できれば、オバマ元大統領のしゃべっている内容を、プーチン大統領にそのまましゃべらせるという映像が作れてしまうわけです。

音声録音の様子を撮影しておけば、口の動きを一致させる形での吹き替え版が作成可能。映画制作に利用されることも十分に考えられます。

また、これまでの映像編集では、人物を動かすと、それに伴って背景を処理する必要がありましたが、Deep Videoでは背景まで勝手に最適化されます。以下は左から、ソースとなる役者の頭の動き、真ん中がDeep Videoで役者の動きをオバマ元大統領に移植した様子、右側がこれまでの技術を用いて編集を行った様子。これまでの技術では頭の動きを移植すると、背景までゆがんでいたのがよくわかります。

完成した映像は実物と見間違うほどにリアル。左側が実際に撮影されたムービー、右側がDeep Videoで作られたものですが、細かな表情の変化や動きまで似通っていて、どちらが偽者かぱっと見ただけでは判別できません。

今回のような顔の映像の合成システムと声まねや音声合成システムとを組合わせれば、人を中傷したり、いわゆる「フェイクニュース」の作成に使われる危険性があります。Zollhöfer准教授は、「現時点では、編集されたムービーの多くは『人工物だ』と見抜くことができます。しかし、人間の目では本物か偽者かを見分けることができない『フェイク』ムービーがいつ登場するのかは、予測が非常に難しいところです」と語っています。一方で、電子透かしを利用したり、あるいはAI技術を使ったりすることで、本物であるかフェイクであるかは判別可能になるという見方もあります。

「私個人の意見としては、最も重要なのは一般大衆が現代のムービー作成・編集技術の能力に気づくことだと考えています」「これにより、私たちは毎日消費するムービーコンテンツに対して批判的に考えるようになるでしょう」とZollhöfer准教授は述べました。

https://web.stanford.edu/~zollhoef/papers/SG2018_DeepVideo/page.html

0 件のコメント:

コメントを投稿